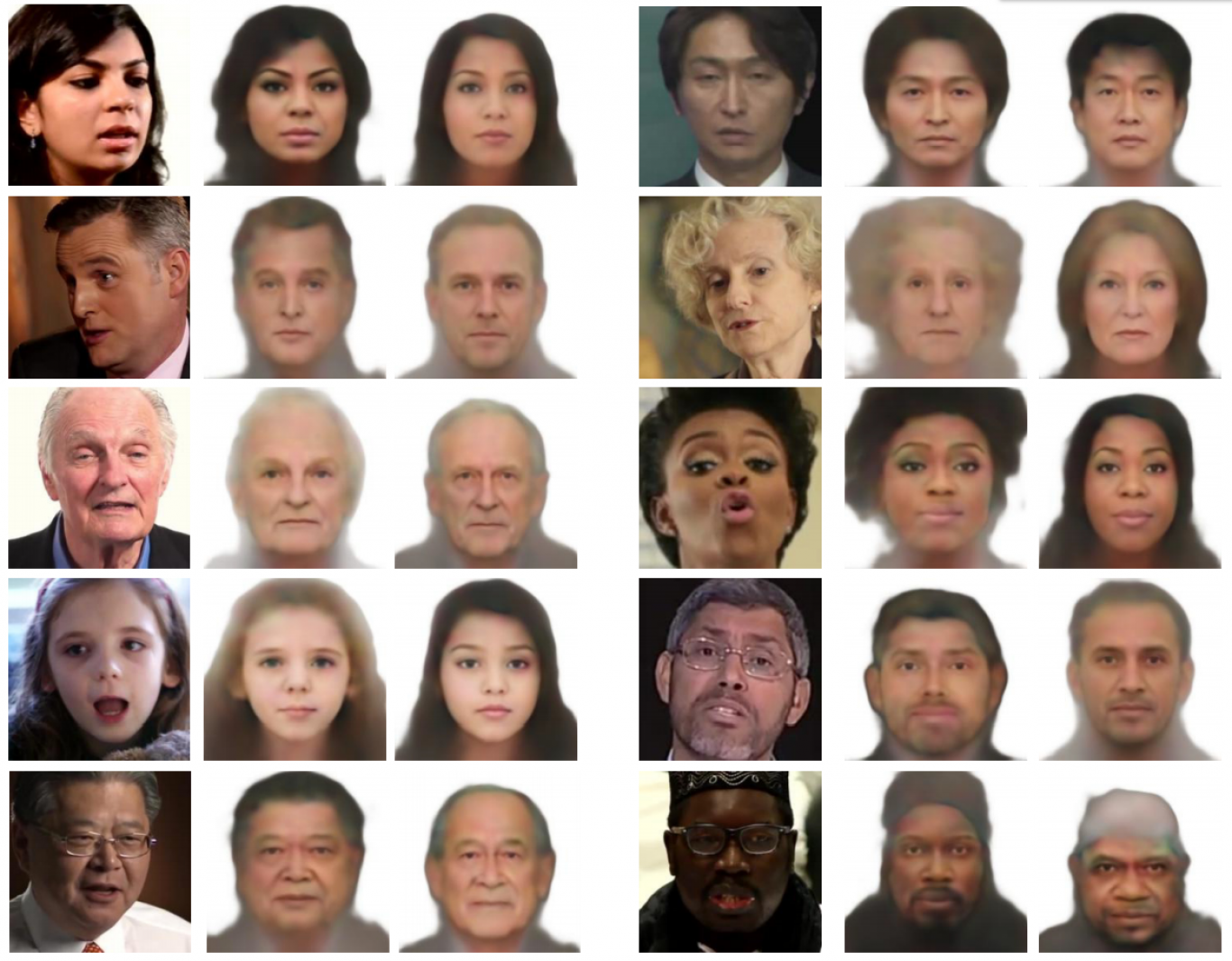

Azt eddig is tudtuk a mesterséges intelligenciával rendelkező neurális hálózatokról, hogy tökéletesen élethű emberi arcképeket tudnak generálni hatalmas adathalmazokból, de ezt a képességüket most már a hangfelismerő technológiákkal is tudják ötvözni – számoltak be a Massachusettsi Műszaki Egyetem (MIT) számítógép-tudománnyal és mesterséges intelligenciával foglalkozó intézetének (CSAIL) kutatói.

A Speech2Face névre keresztelt neurális hálózat betanításához több millió Youtube-videót használtak fel, hogy a bennük szereplő emberek arcvonásai és hangja közti összefüggések alapján később a videóktól független hangok alapján is tudjon fotorealisztikus arcképet rajzolni a mesterséges intelligencia.

Persze a technológia egyelőre nem képes pontos arcmást generálni hang alapján, de a hangunkat befolyásoló főbb jellemzőkről már van némi fogalma – ide tartozik az életkor, a nem, az etnikum, a száj formája, az arccsontok felépítése vagy az ajkak teltsége. De még olyan beszédjegyek is hatottak az arckép alakulására, mint a beszélt nyelv, az akcentus és a beszéd gyorsasága, amik nemzetiségekre és kultúrákra utalhatnak, így bizonyos fizikai vonásokat is előrevetíthetnek.

Bár a nemet, az életkort és az etnikumot tekintve már közel tökéletes az algoritmus felismerőképessége, a nyelvi akadályokat még nem tudta leküzdeni. A tanulmányban például az szerepel, hogy amikor egy ázsiai férfi kínaiul beszélt, a hálózat egy ázsiai arcot rajzolt le, de amikor ugyanaz az ember angolul beszélt, már egy fehér férfi arcát generálta.